Arama motorlarının web sitelerini doğru şekilde tarayabilmesi için robots.txt dosyası büyük önem taşır.

Basit bir metin dosyası gibi görünse de sitenin hangi sayfalarının taranabileceğini veya hariç tutulacağını belirleyen bu dosya, teknik SEO’nun temel yapı taşlarından biridir.

Yanlış yapılandırıldığında, organik görünürlüğün düşmesine, kritik içeriklerin dizine eklenmemesine ya da sitenin hiç taranamamasına yol açabilir.

Özellikle e-ticaret ve içerik ağırlıklı sitelerde yapılan küçük hatalar bile ciddi trafik kayıplarına sebep olabilir.

Bu nedenle robots.txt dosyasında sık yapılan hataları bilmek ve doğru çözümlerle bunları önlemek, arama motorlarında güçlü bir varlık için kritik önem taşır.

Bu yazımızda robots.txt dosyası sık yapılan hatalardan ve bunların çözüm yollarından bahsettik.

İçerik Başlıkları

ToggleRobots.txt Dosyasının Faydaları

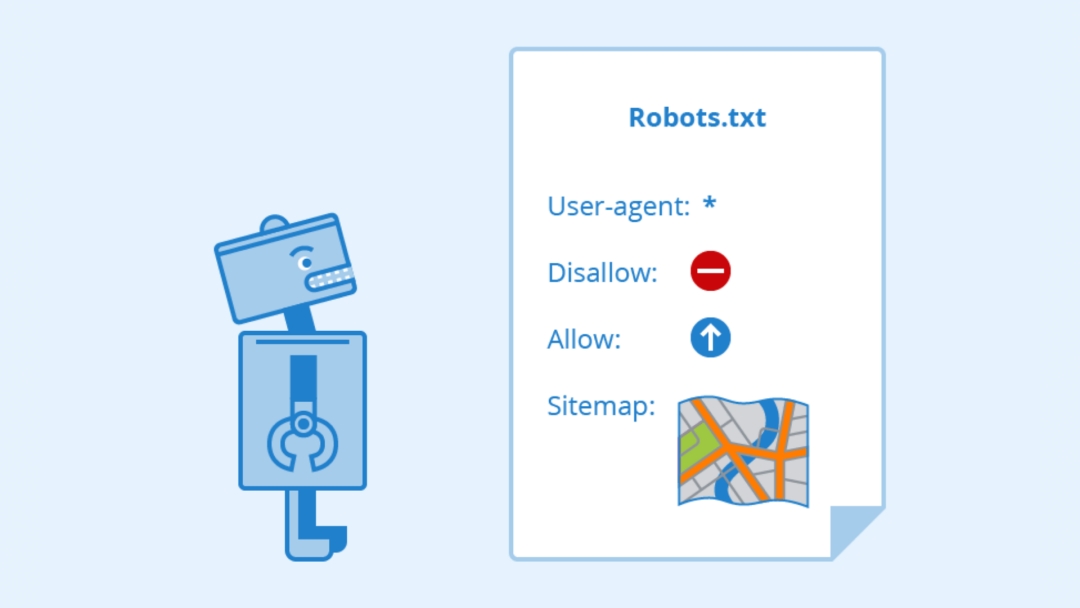

Robots.txt dosyası, web sitenizin arama motorlarıyla sağlıklı bir şekilde iletişim kurmasını sağlayan temel araçlardan biridir.

Bu basit metin dosyası, site sahiplerinin botlara hangi sayfaları tarayıp hangilerini taramayacaklarını belirtmelerine olanak tanır.

Özellikle büyük ve içerik odaklı sitelerde robots.txt, SEO stratejilerinin teknik temelini güçlendirir.

Arama motoru tarama bütçesini yönetmek robots.txt’nin en önemli avantajlarından biridir.

Büyük sitelerde gereksiz sayfaların veya filtrelenmiş içeriklerin taranması sunucuya ek yük bindirir ve önemli sayfaların taranmasını geciktirir.

Doğru yapılandırılmış bir robots.txt ile botlar yalnızca kritik sayfaları tarar, böylece hem tarama bütçesi verimli kullanılır hem de arama motorlarındaki görünürlük artar.

Ayrıca, robots.txt gizli veya özel sayfaların korunmasına yardımcı olur. Yönetici panelleri, test sayfaları veya filtrelenmiş arama sonuçları gibi alanlar, kullanıcıya açık olmamalıdır.

Bu sayfaları taramaya kapatmak, hassas içeriklerin arama sonuçlarında görünmesini engeller. Benzer şekilde, yoğun bot trafiğinin sunucu performansına olumsuz etkisi olabilir.

Robots.txt ile botların erişim sıklığı ve izin verilen dizinler sınırlandırılarak sunucu yükü azaltılabilir.

Site haritası bilgisi sağlamak da robots.txt’nin faydalarındandır. Sitemap URL’sini dosyaya eklemek, arama motorlarının site yapısını daha hızlı anlamasına yardımcı olur.

Bu, özellikle yeni sayfaların hızlı şekilde dizine eklenmesini sağlamak ve indeksleme sürecini hızlandırmak açısından kritik bir noktadır.

Robots.txt Dosyasında Sık Yapılan Hatalar ve Çözümleri

Web sitelerinin arama motorlarında doğru şekilde taranabilmesi ve indekslenebilmesi için robots.txt dosyası oldukça önemli bir rol oynar. Basit bir metin dosyası gibi görünse de yanlış yapılandırıldığında sitenizin görünürlüğünü olumsuz etkileyebilir.

Küçük bir hata, arama motorlarının sitenizi hiç taramamasına ya da önemli sayfalarınızın dizine eklenmemesine neden olabilir. Bu nedenle robots.txt dosyasında en sık yapılan hataları bilmek ve bunlara karşı doğru çözümleri uygulamak, SEO stratejinizin temel parçalarından biridir.

Robots.txt Dosyasının Hiç Olmaması veya Yanlış Konumda Bulunması

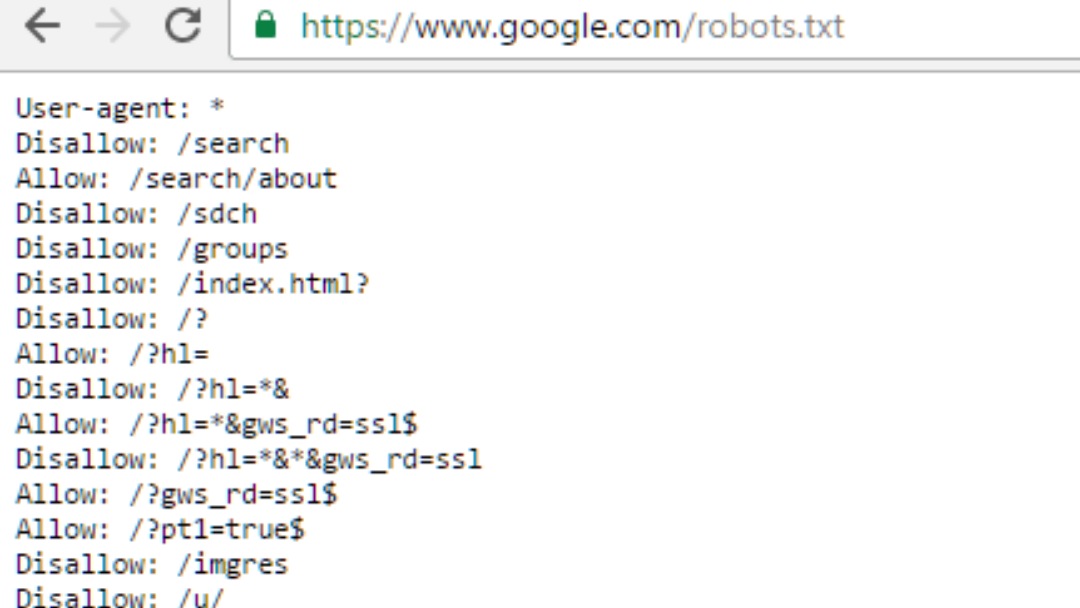

Web sitenizde robots.txt dosyasının bulunmaması veya alt dizinlerde yer alması, en yaygın ve kritik hatalardan biridir. Arama motoru botları, dosyayı yalnızca sitenin kök dizininde arar. Örneğin, https://www.orneksite.com/config/robots.txt adresinde yer alan bir dosya, Google ve Bing tarafından yok sayılır.

Bu durum, tüm sayfaların kontrolsüz şekilde taranmasına ve tarama bütçesinin boşa harcanmasına yol açar.

Böyle bir hatayı çözmek için dosya mutlaka kök dizine yerleştirilmelidir. https://www.orneksite.com/robots.txt. İçerik yönetim sistemlerinin varsayılan yükleme dizinleri, kök dizin dışında olabilir; bu durumda dosya taşınmalı veya sistem ayarlarıyla kök dizine yönlendirilmelidir.

404 ve 5xx Hataları

Robots.txt dosyasına erişimde sunucu hataları meydana gelmesi de sık rastlanan bir sorundur. 404 hatası durumunda Google, robots.txt yokmuş gibi davranır ve tüm siteyi taramaya çalışır.

5xx sunucu hatalarında ise botlar kısa bir süre bekleyip dosyayı tekrar çekmeye çalışır. Ancak uzun süreli hatalarda, tarama tamamen rastgele gerçekleşebilir.

Çözüm için de sunucunuzun robots.txt’ye her zaman erişebildiğinden emin olun ve HTTP 200 yanıt kodu döndüğünü test edin. Dosyanın düzgün çalıştığını doğrulamak için Google Search Console’daki test aracını kullanabilirsiniz.

Slash (/) Kullanım Hataları

Robots.txt’de slash karakterinin yanlış veya eksik kullanımı, beklenmedik tarama sorunlarına yol açabilir. Örneğin, Disallow: /blog yazarsanız /blog sayfası engellenir, ancak /blog/post1.html gibi alt sayfalar taramaya açık kalır.

Bunu çözmek için,eğer tüm /blog dizinini engellemek istiyorsanız, Disallow: /blog/ şeklinde yazılmalıdır. Slash karakterine dikkat ederek hangi sayfaların taramaya kapatıldığını net şekilde belirlemek gerekir.

Allow ve Disallow Komutlarının Yanlış Kullanımı

Allow ve Disallow komutlarının karmaşık ve çelişkili kullanımı kafa karışıklığı yaratır. Örneğin, /urunler/ dizinini taramaya kapatıp içindeki /urunler/erkek/ alt dizinini açık bırakmak istiyorsanız, doğru yazım şöyle olmalıdır:

Disallow: /urunler/

Allow: /urunler/erkek/

Google gibi gelişmiş botlar bu kuralları doğru yorumlar, ancak daha az gelişmiş botlar hatalı davranabilir. Çözüm için, karmaşık kurallardan mümkün olduğunca kaçının ve Allow/Disallow kombinasyonlarını test ederek çalıştığından emin olun.

Büyük/Küçük Harf Uyumsuzluğu

Robots.txt dosyası büyük ve küçük harfe duyarlıdır. Örneğin /Admin/ ile /admin/ farklı dizinler olarak değerlendirilir. Yanlış yazılan dizinler engelleme kurallarının çalışmamasına ve istenmeyen sayfaların taranmasına neden olur. Çözüm için, dosyadaki tüm dizin isimlerini sitenizin gerçek dizin yapısına uygun şekilde yazın ve test edin.

Noindex ile Robots.txt’yi Karıştırmak

Robots.txt yalnızca taramayı sınırlar ancak dizinlenmeyi engellemez. Eğer bir sayfayı arama sonuçlarından tamamen gizlemek istiyorsanız, noindex meta etiketi veya HTTP başlığı kullanmalısınız.

Robots.txt ile taramaya kapattığınız sayfaya noindex etiketi ekleseniz bile botlar sayfayı göremeyeceği için dizinlemeden çıkaramayabilir. Çözüm için, gizlemek istediğiniz sayfalarda önce taramayı açın, noindex etiketi uygulayın ve sayfa dizinden kaldırıldıktan sonra gerekirse tekrar robots.txt ile engelleyin.

Test Ortamı Sitelerinin Taramaya Açık Olması

Staging veya test sitelerinin taranması, duplicate content sorununa yol açabilir. Bir test ortamını yayına almayı unutup tüm botlara açık bırakırsanız, ana sitenizle aynı içerikler arama motorlarında çakışabilir. Çözüm için test sitelerinde User-agent: * Disallow: / kullanarak taramayı engelleyin. Yayına geçerken bu kuralı kaldırmayı unutmayın.

Joker Karakterlerin Yanlış Kullanımı

* ve $ gibi joker karakterlerin yanlış kullanımı, sitenizin beklenenden daha fazla bölümünü engelleyebilir. Örneğin yanlış yerleştirilmiş Disallow: /*.html$ tüm HTML sayfalarını engelleyebilir.

Çözüm için joker karakterleri dikkatle kullanın ve test araçlarıyla doğrulayın. Gereksiz karmaşıklıktan kaçının.

CSS ve JS Dosyalarının Engellenmesi

Bazı yöneticiler, botların stil veya komut dosyalarına erişimini engeller. Ancak bu, sayfanın doğru render edilmesini önler. Google bot, eksik CSS/JS nedeniyle sayfayı hatalı görür ve mobil uyumluluk ile kullanıcı deneyimi puanları düşer. Çözüm için, stil ve komut dosyalarını taramaya açık bırakın. Yalnızca gerçekten gizlenmesi gereken kaynakları engelleyin.

Sitemap URL’sinin Eklenmemesi

Site haritası bilgisi robots.txt’ye eklenmezse arama motorları site yapısını daha geç keşfeder. Bu durum, yeni sayfaların dizine eklenmesini yavaşlatır. Çözüm için robots.txt dosyanızın sonuna sitemap URL’sini ekleyin:

Sitemap: https://www.orneksite.com/sitemap.xml

Robots.txt Dosyasının Boyutu ve Kodlama Sorunları

Google, robots.txt dosyalarında maksimum 500 KiB sınırı uygular. Büyük dosyalardaki kurallar göz ardı edilebilir. Ayrıca UTF-8 dışında kaydedilmiş dosyalar bazı botlar tarafından okunamayabilir. Çözüm için, dosyayı sadeleştirin, gereksiz kuralları çıkarın ve UTF-8 formatında kaydedin.

Alt Alan Adları İçin Tek Dosya Kullanılması

Her alt alan adı için ayrı robots.txt dosyası gerekir. Ana alan adındaki dosya alt alanlar için geçerli değildir. Çözüm olarak, her subdomain için kendi robots.txt dosyasını oluşturun ve doğru şekilde konumlandırın.

Özetle; robots.txt dosyası, sitenizin arama motorlarıyla sağlıklı bir iletişim kurmasını sağlayan kritik bir SEO aracıdır.

Ancak yanlış konumlandırma, slash hataları, Allow/Disallow çelişkileri, büyük/küçük harf uyumsuzlukları, test sitelerinin açık kalması veya CSS/JS dosyalarının engellenmesi gibi hatalar, sitenizin görünürlüğünü ciddi şekilde olumsuz etkileyebilir. Bu nedenle dosyanın doğru yapılandırılması, erişilebilir olması ve sitemap URL’sinin eklenmesi şarttır.

Ayrıca joker karakter kullanımına dikkat etmek, noindex ile karıştırmamak ve her alt alan adı için ayrı dosya oluşturmak hem tarama bütçenizi optimize eder hem de kritik içeriklerin dizine eklenmesini sağlar.

Web sitenizin SEO performansını artırmak ve arama motorlarında güçlü bir varlık oluşturmak için robots.txt dosyanızı mutlaka düzenli olarak kontrol ve test etmeniz gerekir.

Siz de hemen şimdi kendi robots.txt dosyanızı gözden geçirerek sitenizin taranabilirliğini ve görünürlüğünü maksimize edin!